-

生物通官微

陪你抓住生命科技

跳动的脉搏

基于胶囊网络与知识图谱的知识驱动图像描述生成方法研究

《IEEE Access》:Knowledge?Driven Image Captioning

【字体: 大 中 小 】 时间:2025年12月11日 来源:IEEE Access 3.6

编辑推荐:

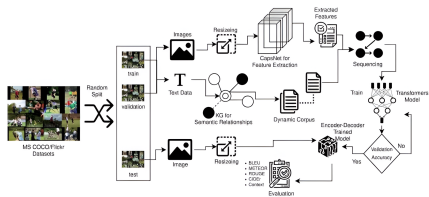

本文推荐一项创新性图像描述生成研究。针对传统方法在几何关系建模和上下文理解方面的不足,研究人员开展了知识驱动图像描述主题研究。他们提出了一种融合胶囊网络(Capsule Networks)、知识图谱(Knowledge Graphs)和Transformer神经网络的三阶段框架,在MSCOCO等数据集上取得了B4: 49.97, M: 39.14, C: 136.53, R: 74.61的优异指标。该研究突破了传统编码器-解码器架构的限制,通过几何感知的特征提取和动态知识检索,显著提升了描述生成的空间准确性和语义丰富度,为多模态人工智能发展提供了新思路。

生物通微信公众号

生物通微信公众号

知名企业招聘