-

生物通官微

陪你抓住生命科技

跳动的脉搏

SparseDFF:一种用于灵巧操作的深度特征学习方法

【字体: 大 中 小 】 时间:2024年07月18日 来源:北京大学新闻网

编辑推荐:

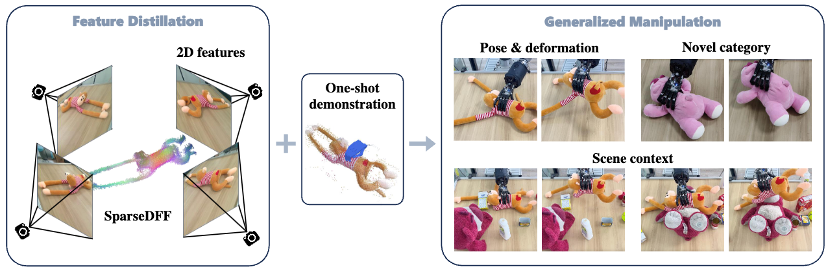

该研究解决了使用预训练视觉模型的语义对应来一次性学习灵巧操作的问题。合作团队开发了一种方法,将稀疏视角的RGB-D观测特征提炼到一个一致的3D场中,并创建了一个用于跨不同场景优化末端执行器参数的能量函数,并将方法应用于灵巧手,展示了研究所提方法在真实世界场景中对新的物体姿势、形变、几何形状和类别的强大泛化能力。

人类与环境的交互以手作为媒介来完成,通过手进行各种操作对我们来说习以为常且必不可少。机器人和环境的交互的媒介是末端执行器(End Effector)——它可以是一个夹子、一个吸盘,也可以和人类一样,是一双灵巧手(Dexterous Hand)。教会机器人使用灵巧手意义重大,因为机器人需要一个和人类似的手才可以使用各种专为人类设计的工具,融入人类的生活环境。然而到目前为止,用灵巧手操作(甚至是抓取)物体仍是一个亟待解决的难题。

图1. 机器手抓取玩偶猫

近日,北京大学人工智能研究院朱毅鑫助理教授课题组及合作者在计算机视觉顶级会议CVPR 2024发表论文 “SparseDFF:Sparse-View Feature Distillation for One-Shot Dexterous Manipulation”。该研究提出了SparseDFF——一种用于灵巧操作的深度特征学习方法,它通过蒸馏的方式优化2D视觉大模型特征同时构建3D特征场,使机器人能够像人类一样理解不同实例之间的语义对应关系,从而通过优化的方法在多种场景实现高效的one-shot灵巧操作迁移。通过真机实验表明,SparseDFF是相同实验设置下最先进(SOTA)的灵巧抓取方法。

在人工智能领域,人们也希望机器具有这种举一反三的学习能力(在人工智能领域称其为“泛化”),而传统的模仿学习和强化学习面临着数据需求量大、泛化性差、成功率低等问题。考虑到人类的学习方法,过程包含了对部几何结构和语义信息的深层理解。

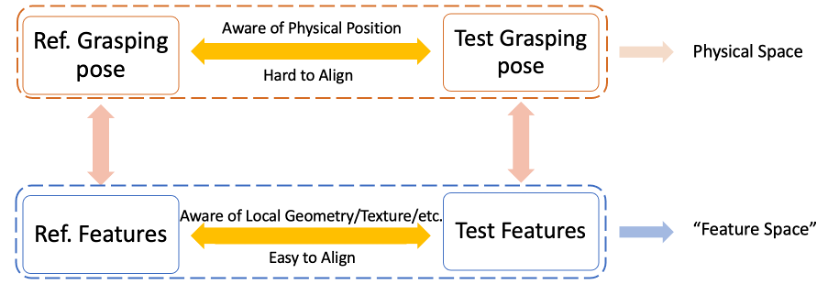

图2. 相似抓取位姿可在高维特征空间中对齐

在传统计算机视觉中,常常用特征表示图片内容的信息,而直接对齐机器人姿势是非常困难的。研究者们提出构建更高级的特征场(Feature Field),同时具有语义、几何和视觉的潜在信息。在这个空间中的任何抓取姿势都会对应一个特征。将一个示范的抓取姿势和新场景中待优化的抓取姿势分别映射到各自的特征空间中,并通过优化的方法使两个特征在特征空间中对齐,从而使得得到的抓取姿势能够抓取物体。

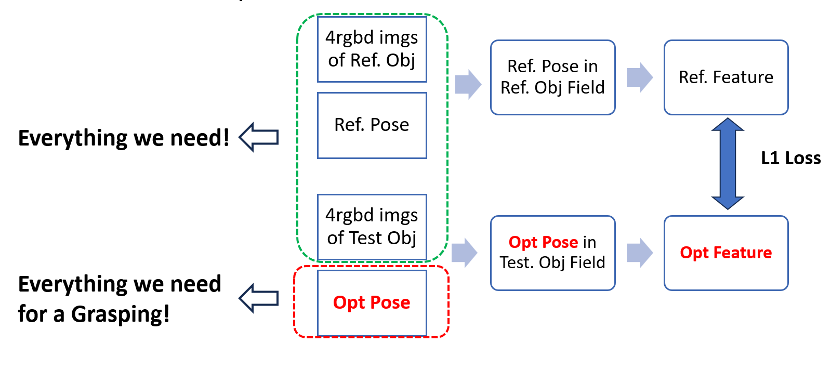

图3. SparseDFF方法简图

研究者们提出了一个稀疏视角单样本灵巧抓取技能迁移方法。仅需要一次示范,即能将同样的操作技能直接迁移到同类的任何不同姿势的物体上。利用预训练视觉模型DINO蒸馏信息来构建特征场,满足了少训练数据、强泛化性和高成功率的要求。此种方法速度很快。仅需要一张RTX3090显卡、在示范场景中学习5分钟,之后每次生成新场景的抓取姿势只需要20秒。在软体和刚体上的真机实验均获得好的效果。

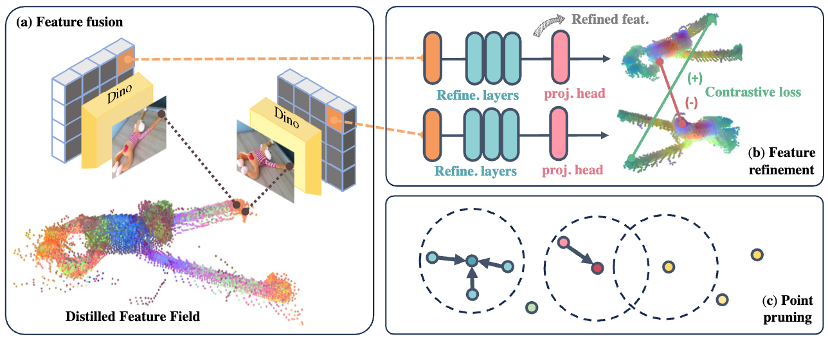

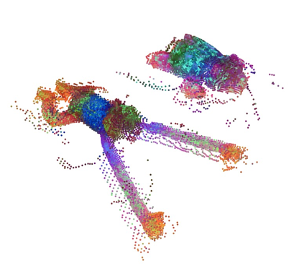

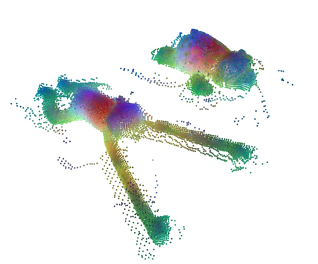

图4. 构建蒸馏特征场

如图 4(a)所示,研究者们采取3D特征蒸馏的方法来构建3D特征场。不同于以往结合NeRF表示法直接重建连续的隐式特征场,我们将DINO应用于RGB图像,采用提炼离散的3D点的方法,将他们传播到周围空间,利用像素和点的对应关系直接将其投影到每个点云,产生每个点的特征。

图5. 优化前的特征场

图6. 优化后特征场

在初步构建了优化前的特征场(图5)中的点云后,合作团队设置了特征优化网络。训练此网络仅需在单一场景中进行自监督学习。训练完成后,他们直接将这个特征优化网络应用于新的实验场景中,以增强特征之间的连续性,从而获得更高质量的特征,并构建修剪机制【图 4(c)所示】,进一步增强生成点云特征的一致性。团队利用剪枝后的点云来获取灵巧手的特征,通过获得的特征差异进行末端优化,减少实验和示范物体的特征差异,获取最终抓取位姿。

末端执行器优化

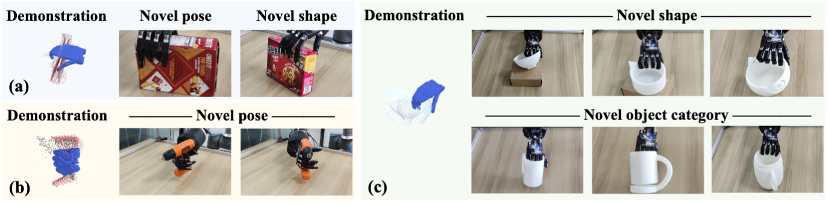

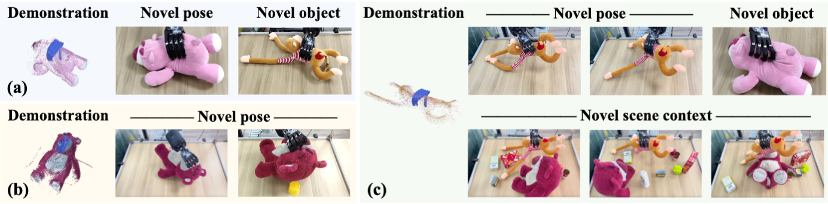

合作团队采用构建的算法,对多种物体进行定量测试。在刚体测试中,他们使用了钻头、两种盒子、三种碗和三种杯子来验证,并将其成功率与UniGraspDex++以及DFF进行对比。实验结果显示,相同物体不同姿态和不同物体的泛化,所提出的算法都显著提高了成功率,在泛化到不同物体时效果尤为明显。在柔性物体测试中,他们使用毛绒玩具猴子和玩具熊进行实验,将抓取毛绒玩具猴的特征泛化到抓取不同姿态的毛绒玩具猴、周围有许多杂乱干扰物体的毛绒玩具猴和小毛绒玩具熊上,验证了所提出的方法在不同姿态泛化、嘈杂环境抗干扰性和不同物体一致性上的优势,对比了所提方法与DFF 执行抓取大玩具熊的鼻子的任务,并将毛绒玩具熊的特征泛化到不同姿态的玩具熊和玩具猴,验证所提出的模型在泛化到不同物体的实验上发挥的稳定性。

图8. 刚性物体实验

图9. 柔性物体实验

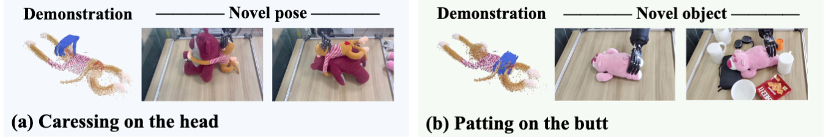

图10. 语意丰富的操作任务

此外,研究者们进行了附加实验,以证明所提出的方法不仅局限于抓取任务。结果表明,算法能够掌握丰富的语义含义,并迁移到不同姿势和物体上,表现出良好的泛化能力。

该研究解决了使用预训练视觉模型的语义对应来一次性学习灵巧操作的问题。合作团队开发了一种方法,将稀疏视角的RGB-D观测特征提炼到一个一致的3D场中,并创建了一个用于跨不同场景优化末端执行器参数的能量函数,并将方法应用于灵巧手,展示了研究所提方法在真实世界场景中对新的物体姿势、形变、几何形状和类别的强大泛化能力。

论文第一作者为北京大学信息科学技术学院2021级本科生王乾旭,通讯作者为斯坦福大学教授Leonidas Guibas、朱毅鑫、斯坦福大学在读博士邓丛悦。